Em 2025, os deepfakes atingiram um nível de sofisticação sem precedentes, tornando-se quase indistinguíveis da realidade para o público comum e, em muitos casos, até para especialistas. Essa evolução drástica da mídia sintética, impulsionada por avanços em inteligência artificial, representa um desafio crescente para a detecção e autenticidade da informação digital. A proliferação desses conteúdos enganosos exige uma nova vigilância no cenário online.

A qualidade dos rostos, vozes e performances de corpo inteiro geradas por IA superou as expectativas, replicando pessoas reais com fidelidade assustadora. Este salto tecnológico não apenas elevou o realismo a patamares críticos, mas também impulsionou um aumento exponencial no volume de deepfakes em circulação, complicando a distinção entre o genuíno e o fabricado, conforme reportado pela Fast Company.

A firma de cibersegurança DeepStrike estima um crescimento de cerca de 500.000 deepfakes online em 2023 para impressionantes 8 milhões em 2025, um aumento anual próximo de 900%. Essa explosão quantitativa e qualitativa sinaliza um futuro onde a verificação de conteúdo se tornará uma tarefa ainda mais complexa, com previsões de que a situação se agrave em 2026, à medida que a mídia sintética ganhe capacidade de reagir em tempo real.

A engenharia por trás da indistinguibilidade

Os avanços técnicos que sustentam essa escalada dramática são notáveis. Modelos de geração de vídeo foram desenvolvidos especificamente para manter a consistência temporal, resultando em vídeos com movimento coerente, identidades consistentes das pessoas retratadas e conteúdo que faz sentido de um quadro para o outro.

Esses modelos conseguem separar as informações relacionadas à identidade de uma pessoa daquelas sobre o movimento. Isso permite que o mesmo movimento seja mapeado para diferentes identidades, ou que uma mesma identidade execute múltiplos tipos de movimentos.

O resultado são rostos estáveis e coerentes, sem o cintilar, deformações ou distorções estruturais ao redor dos olhos e mandíbula que antes serviam como evidências forenses confiáveis de deepfakes. Ferramentas como o MOVAI (Multimodal Original Video AI) e técnicas de interpolação neural de quadros, como as usadas pela Reelmind.ai, são exemplos de como a inteligência artificial está superando os desafios da consistência espacial e temporal na geração de vídeo.

O impacto crescente na segurança e informação

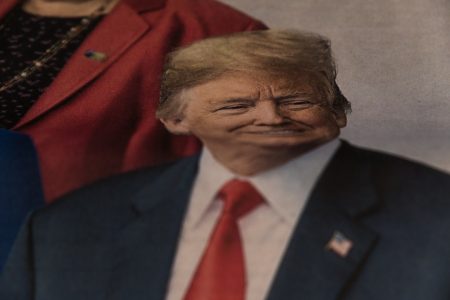

A proliferação de deepfakes em 2025 tem gerado uma crise de autenticidade digital, minando a confiança que os usuários depositam na mídia online. A dificuldade crescente em distinguir entre mídia autêntica e sintética desorganiza o ecossistema da informação, permitindo que agentes mal-intencionados manipulem narrativas e desacreditem evidências legítimas.

Ameaças como a desinformação política, fraudes financeiras e ataques de engenharia social, onde golpistas personificam figuras de autoridade para extrair informações sensíveis ou autorizar transações, tornaram-se mais frequentes. Incidentes de fraude impulsionados por deepfakes aumentaram drasticamente, com um ataque ocorrendo a cada cinco minutos.

Um exemplo alarmante em 2024 envolveu um trabalhador financeiro em Hong Kong que transferiu 25 milhões de dólares para fraudadores que usaram tecnologia deepfake para se passar pelo diretor financeiro da empresa em uma videochamada. Até mesmo a integridade dos sistemas de justiça criminal é desafiada, pois vídeos, fotos ou áudios podem ser sinteticamente gerados para apoiar álibis falsos ou evidências exoneratórias.

Diante da rápida evolução dos deepfakes, a necessidade de ferramentas de detecção mais avançadas e de uma educação digital robusta torna-se imperativa. A fronteira entre o real e o artificial nunca foi tão tênue, exigindo uma reavaliação contínua sobre como consumimos e confiamos na informação online. Competições como o Desafio de Detecção e Localização de Deepfakes (DDL) na IJCAI 2025 buscam aprimorar a capacidade de localizar falsificações e mitigar ameaças multimodais.

O ano de 2026 promete intensificar esse cenário, demandando inovação constante para salvaguardar a integridade do ambiente digital, como apontado por especialistas. Apenas 24,5% dos humanos conseguem detectar deepfakes de alta qualidade com precisão, sublinhando a urgência de soluções tecnológicas e marcos regulatórios. Países como a Dinamarca já introduziram leis que concedem aos cidadãos direitos autorais sobre seus próprios rostos, tornando ilegal o compartilhamento de deepfakes baseados em pessoas reais.