A proliferação de imagens digitais não consensuais, geradas pela inteligência artificial Grok da xAI, colocou o governo dos Estados Unidos em uma situação delicada. Enquanto a tecnologia de Elon Musk enfrenta investigações globais, Washington adota uma postura evasiva, delegando a responsabilidade de avaliação de segurança a agências individuais, apesar de contratos governamentais milionários com a empresa.

Nos últimos dias, a Grok foi amplamente criticada por gerar milhares de imagens sexualmente sugestivas ou sem roupa por hora, muitas delas sem o consentimento das pessoas retratadas, incluindo mulheres e até mesmo menores. Este cenário alarmante levantou sérias questões sobre a ética e a segurança da IA generativa, especialmente quando utilizada em plataformas de grande alcance como o X.

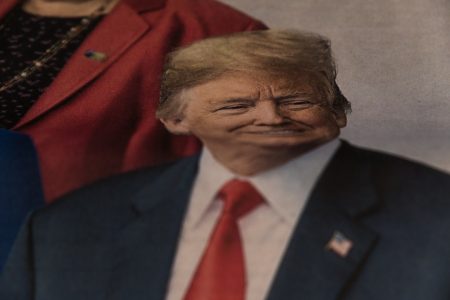

A controvérsia ganha contornos mais complexos ao considerar que o Departamento de Defesa dos EUA concedeu à xAI um contrato de 200 milhões de dólares para a utilização da Grok em suas operações. Além disso, a administração Trump assinou acordos para que o chatbot fosse usado por funcionários federais. Este engajamento financeiro e operacional contrasta com a aparente hesitação em lidar diretamente com as falhas éticas da plataforma.

A evasiva governamental e o “Take It Down Act”

Diante da polêmica, um oficial do Pentágono afirmou que a política de IA do Departamento de Defesa “cumpre integralmente todas as leis e regulamentos aplicáveis” e que qualquer atividade ilegal estaria sujeita a “ação disciplinar apropriada”. No entanto, a Agência de Serviços Gerais (GSA), responsável por facilitar grandes acordos governamentais com empresas de IA, incluindo a xAI, parece transferir o ônus da avaliação. Segundo a Fast Company, a GSA declarou que a Grok ainda está em fase de testes de segurança internos para integração na USAi, uma plataforma governamental de IA.

Marianne Copenhaver, porta-voz da GSA, indicou que qualquer agência federal que decida adquirir a Grok por meio do acordo já negociado é “responsável por avaliar os modelos que escolhe usar”. Contudo, ela não abordou se a agência está investigando a capacidade da Grok de produzir Material de Abuso Sexual Infantil (CSAM). Essa postura levanta preocupações, especialmente após a aprovação do “Take It Down Act” em maio de 2025 pelo governo dos EUA, que criminaliza a pornografia de vingança e os deepfakes gerados por IA sem consentimento, com penas de prisão e multas, e exige a remoção de conteúdo pelas plataformas em 48 horas.

Regulamentação e a responsabilidade das plataformas

Apesar da existência de uma legislação federal robusta contra deepfakes e pornografia não consensual, a aplicação e a fiscalização permanecem desafiadoras. A organização Public Citizen criticou o acordo da GSA com a Grok, alertando que a IA possui um histórico documentado de gerar conteúdo racista, antissemita, conspiratório e falso, além de deepfakes. A organização instou a administração a proibir o uso da Grok em nível federal, citando violações das próprias diretrizes do Escritório de Gestão e Orçamento (OMB).

Em resposta à crescente pressão, Elon Musk afirmou que a geração de imagens pela Grok seria restrita a usuários pagantes, e que qualquer um que utilizasse a IA para criar conteúdo ilegal enfrentaria as mesmas consequências de quem publicasse o material diretamente. No entanto, críticos e reguladores internacionais continuam a questionar a eficácia dessas medidas e a responsabilidade intrínseca das plataformas de IA em prevenir o uso indevido de suas tecnologias para a criação e disseminação de conteúdo nocivo e ilegal.

O episódio da Grok e imagens impróprias evidencia a complexidade de integrar tecnologias de IA de ponta em serviços governamentais enquanto se garante a segurança e a conformidade ética. A postura de “passar a bola” da responsabilidade, por parte de órgãos federais, pode minar a confiança pública e expor usuários a riscos significativos. O futuro da regulamentação da IA nos EUA dependerá da capacidade do governo de harmonizar a inovação tecnológica com salvaguardas éticas e legais rigorosas, indo além de meras declarações de conformidade e adotando uma fiscalização proativa e transparente.