Em 2026, a proteção das crianças no ambiente digital se tornou uma prioridade global, com governos, plataformas e ativistas unindo esforços para criar um espaço online mais seguro. A preocupação com o tempo de tela excessivo e o acesso a conteúdos impróprios tem impulsionado uma onda de novas regulamentações e o desenvolvimento de tecnologias de verificação de idade.

A urgência é palpável, especialmente diante do avanço da inteligência artificial e da proliferação de plataformas que, como o Grok da xAI, podem gerar respostas não censuradas em segundos, levantando alarmes sobre conteúdo prejudicial. Legisladores, muitas vezes motivados por manchetes sobre saúde mental, extremismo e exploração sexual, buscam soluções em proibições, limites de uso e mecanismos rigorosos de verificação de idade.

O debate regulatório, contudo, é complexo. Catalina Goanta, professora associada de direito privado e tecnologia na Universidade de Utrecht, na Holanda, observa que o foco atual parece ser em como certos serviços da internet são “negativos líquidos”, resultando em uma abordagem de “tudo ou nada”. Ela argumenta que a discussão científica revela um cenário muito mais nuançado sobre o que pode ser prejudicial a menores, dependendo de múltiplos fatores além de simplesmente ter um telefone em mãos.

O avanço das regulamentações e seus desafios

Diversas nações estão implementando e reforçando leis para proteger os jovens usuários. No Brasil, o Estatuto da Criança e do Adolescente (ECA) ganhou uma atualização significativa com a Lei 15.211/2025, conhecida como “ECA Digital”. Esta legislação, sancionada em setembro de 2025 e com fiscalização a partir de março de 2026, estabelece normas para ampliar a proteção integral de crianças e adolescentes em plataformas digitais, incluindo redes sociais, aplicativos e jogos eletrônicos.

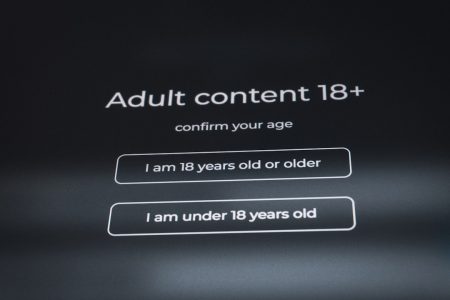

As novas regras do ECA Digital exigem que plataformas adotem mecanismos confiáveis de verificação de idade, impedindo o acesso apenas por autodeclaração. Contas de usuários com menos de 16 anos deverão ser vinculadas a um responsável legal, que terá a capacidade de acompanhar atividades, definir limites e autorizar interações. Além disso, a lei proíbe publicidade direcionada por perfilamento comportamental e outras formas de monetização que explorem dados de crianças e adolescentes. O Comitê Gestor da Internet no Brasil (CGI.br) já apresentou recomendações para a implementação proporcional e inclusiva desses mecanismos de verificação.

Nos Estados Unidos, a Children’s Online Privacy Protection Act (COPPA) também passou por emendas significativas em abril de 2025, com plena conformidade esperada até abril de 2026. Essas mudanças buscam adaptar a legislação à evolução dos serviços online e às preocupações com a privacidade de dados. Contudo, a implementação dessas leis não ocorre sem resistência. Organizações como a NetChoice, que inclui membros como Amazon, Google e Meta, têm desafiado judicialmente diversas leis estaduais de verificação de idade e limites de uso, argumentando que elas podem infringir a liberdade de expressão. Adam Kovacevich, fundador da Chamber of Progress, uma coalizão de políticas da indústria de tecnologia, observa que algumas dessas discussões são, inclusive, impulsionadas por grandes empresas de tecnologia como forma de se posicionar defensivamente.

O impacto na saúde mental e as inovações tecnológicas

A preocupação com a saúde mental dos jovens é um dos principais catalisadores para essas mudanças. Relatórios indicam que a crise de saúde mental entre crianças e adolescentes atingiu um ponto crítico, exacerbada pela “expansão descontrolada” das redes sociais. Pesquisas da KidsRights e da Universidade Erasmus de Roterdã, divulgadas em 2025, mostram que um em cada sete jovens entre 10 e 19 anos sofre de algum problema de saúde mental, com uma “correlação perturbadora” entre a deterioração da saúde mental infantil e o uso “problemático” das redes.

Especialistas como Pedro Hartung, diretor de Políticas e Direitos das Crianças do Instituto Alana, alertam que a internet se tornou um “campo minado” para crianças e adolescentes, onde a arquitetura digital muitas vezes é pensada para viciar e explorar comercialmente. Em resposta, plataformas como o TikTok estão implementando novas tecnologias para reforçar a verificação de idade, especialmente na Europa, onde a pressão regulatória para identificar e remover contas de menores de 13 anos é intensa. A União Europeia, por meio da Lei de Serviços Digitais (DSA), também estabelece um quadro legal abrangente para a responsabilização de serviços digitais, moderação de conteúdo e transparência, incluindo a proibição de publicidade direcionada a menores com base em perfilagem.

O ano de 2026 marca um ponto de inflexão na segurança online infantil. A colaboração entre governos, indústrias e a sociedade civil é crucial para encontrar um equilíbrio entre a proteção dos direitos fundamentais das crianças e o aproveitamento dos benefícios do mundo digital. A implementação eficaz e constitucional das novas leis, juntamente com o desenvolvimento de tecnologias de proteção e educação digital, será fundamental para construir um futuro online mais seguro e saudável para as próximas gerações.